NVIDIA A100 Tensor コア GPUは、AI、データ分析、HPC(ハイパフォーマンスコンピューティング)における、あらゆる規模で前例のない高速化を実現し、世界で最も困難なコンピューティングの課題に取り組むことができます。NVIDIA データ センター プラットフォームのエンジンとしてA100 は、数千単位の GPU に効果的に拡張できます。あるいは、NVIDIA マルチインスタンス GPU (MIG) テクノロジを利用し、7 個の GPU インスタンスに分割し、あらゆるサイズのワークロードを高速化することができます。また、第3世代 Tensor コアでは、多様なワークロードであらゆる精度が高速化され、洞察を得るまでの時間と製品を市場に届けるまでの時間が短縮されます。

A100 は 、ハードウェア、ネットワーキング、ソフトウェア、ライブラリ、最適化された AI モデル、NGC™のアプリケーションにわたる構成要素を組み込んだ NVIDIA の完全データ センター ソリューション スタックの一部です。データ センター向けとして最もパワフルな AI/HPC 用エンドツーエンド プラットフォームであり、研究者は現実世界で成果をもたらし、ソリューションを大規模な運用環境に展開できます。

AIネットワークは大規模で、数百万から数十億のパラメーターを持っています。正確な予測に、これらのパラメーターのすべてが必要なわけではなく、精度を損なうことなくモデルを「スパース」にするためにゼロに変換できるパラメーターもあります。

A100のTensorコアは、スパースモデルに対して最大2倍のパフォーマンスを提供することができます。スパース性機能はAI推論に役立ちますが、モデルトレーニングの性能を向上させることもできます。

A100 GPUは、最大7つのGPUインスタンスに分割することができ、ハードウェアレベルで完全に分離され、独自の高帯域幅メモリ、キャッシュ、およびコンピューティングコアを備えています。MIGにより、開発者はすべてのアプリケーションのために画期的なアクセラレーションにアクセスすることができ、IT管理者はすべてのジョブに対して適切なGPUアクセラレーションを提供することができ、使用率を最適化し、すべてのユーザーとアプリケーションへのアクセスを拡大することができます。

A100は、大小のワークロードを高速化します。MIGを使用してA100GPUを小さなインスタンスに分割したり、NVLinkを使用して複数のGPUを接続して大規模なワークロードを高速化したりする場合でも、A100は最小のジョブから最大のマルチノード・ワークロードまで、さまざまなサイズのアクセラレーション・ニーズに容易に対応できます。A100の汎用性は、IT管理者が24時間体制でデータセンター内のすべてのGPUを最大限に活用できることを意味します。

A100のNVIDIA NVLinkは、前世代と比較して2倍のスループットを提供します。NVIDIA NVSwitch™と組み合わせることで、最大16個のA100 GPUを最大600ギガバイト/秒(GB/秒)で相互接続することができ、1台のサーバーで可能な最高のアプリケーション性能を発揮します。NVLinkは、HGX A100サーバーボードを介したA100 SXM GPUと、最大で2GPU用のNVLink Bridgeを介したPCIe GPUで利用できます。

A100は、312テラフロップス(TFLOPS)のディープラーニング性能を提供します。これは、NVIDIA Volta™ GPUと比較して、ディープラーニングのトレーニングでは20倍のTensor FLOPS、ディープラーニング推論では20倍のTensor TOPSを実現しています。

40ギガバイト(GB)の高帯域幅メモリ(HBM2)を搭載したA100は、1.6TB/秒という向上したraw帯域幅を実現するとともに、95%という高いダイナミック・ランダムアクセス・メモリ(DRAM)の使用効率を実現しています。A100は、前世代と比較して1.7倍のメモリ帯域幅を提供しています。

AIモデルは、会話型AIのような次のレベルの課題に挑むため、AIモデルの複雑さが爆発的に増しています。これらのモデルのトレーニングには、大規模な計算処理能力とスケーラビリティが必要になります。

NVIDIA A100 TensorコアとTensor Float(TF32)は、コード変更なしでNVIDIA Voltaと比較して最大20倍の性能を発揮し、Automatic Mixed Precision(AMP)とFP16の活用でさらに2倍の性能を発揮します。NVIDIA® NVLink®、NVIDIA NVSwitch™、PCI Gen4、NVIDIA® Mellanox® InfiniBand®、NVIDIA Magnum IO™ SDKと組み合わせることで、数千単位のA100 GPUまでスケールアップすることが可能です。

BERTのようなトレーニングワークロードは、2,048個のA100 GPUで1分以内に大規模に解決することができ、これは解決までの時間の世界記録です。

ディープラーニング・レコメンデーション・モデル(DLRM)のような大規模なデータテーブルを持つ最大のモデルの場合、A100 80GBはノードあたり最大1.3TBのユニファイド・メモリに達し、A100 40GBと比較して最大3倍のスループットを実現します。

トレーニングにおける NVIDIA の優位性は MLPerf 0.6 で実証されました。これは業界全体で使える初の AI トレーニング向けベンチマークです。

A100は、推論ワークロードを最適化するための画期的な機能を導入しています。FP32からINT4まで、あらゆる精度を高速化します。マルチインスタンスGPU(MIG)技術により、1台のA100上で複数のネットワークを同時に動作させ、計算リソースを最適に活用することができます。また、A100 の数々の推論高速化は、スパース行列演算機能によってさらに 2 倍の性能を発揮します。

BERTのような最先端の会話型AIモデルでは、A100はCPUを介して最大249倍の推論スループットを高速化します。

自動音声認識用のRNN-Tのようなバッチサイズに制約のある最も複雑なモデルでは、A100 80GBのメモリ容量の増加により、各MIGのサイズが2倍になり、A100 40GBと比較して最大1.25倍のスループットを実現します。

NVIDIAの市場をリードする性能は、業界初の推論用ベンチマークであるMLPerfInferenceで実証されました。A100は、そのリーダーシップをさらに拡張するために20倍の性能をもたらします。

次世代の新しい技術を開発するために、科学者たちは複雑な分子に対する理解度を上げるシミュレーションを求めています。

NVIDIA A100は、倍精度のTensorコアが搭載されており、HPC向けのGPUの登場以来最大の性能の飛躍を実現しています。80GBの高速GPUメモリと組み合わせることで、研究者はA100で10時間を要していた倍精度シミュレーションを4時間以下に短縮することができます。また、HPCアプリケーションでは、TF32精度を活用して、単精度の密行列積で最大11倍の演算スループットを達成することができます。

最大のデータセットを扱うHPCアプリケーションでは、A100 80GBの追加メモリにより、材料シミュレーションのQuantum Espressoで最大2倍のスループットを実現します。この大容量メモリと前例のないメモリ帯域幅により、A100 80GBは次世代のワークロードに理想的なプラットフォームとなっています。

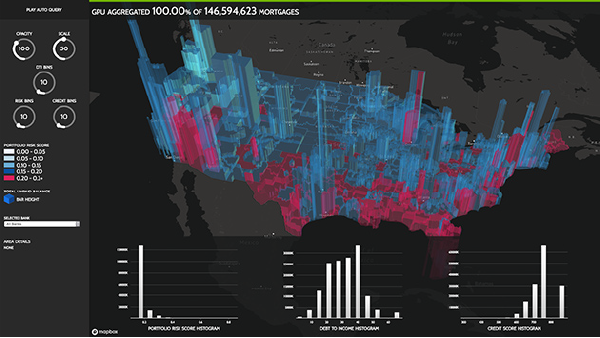

顧客は、膨大なデータセットを分析し、可視化し、洞察に変えることを求めています。しかし、スケールアウトソリューションは、複数のサーバーに分散したデータセットによって、しばしば行き詰ることがあります。

A100を搭載した高速化サーバーは、大容量メモリ、2TB/秒以上のメモリ帯域幅、NVIDIA® NVLink®およびNVSwitch™によるスケーラビリティに加えて、必要な計算処理能力を提供し、これらのワークロードに取り組むことができます。InfiniBand、NVIDIA Magnum IO™、およびオープンソースライブラリのRAPIDS™スイート(RAPIDS Accelerator for Apache Spark for GPU-accelerated data analyticsを含む)と組み合わせることで、NVIDIAデータセンタープラットフォームは、画期的なレベルの性能と効率性で、これらの大規模なワークロードを加速することができます。

ビッグデータ分析のベンチマークでA100 80GBは、CPUの83倍のスループットとA100 40GBと比較して2倍のスループットで洞察を提供し、データセットサイズが爆発的に増加する新しいワークロードに最適です。

MIGを搭載したA100は、GPUアクセラレーションされたインフラストラクチャを最大限に活用します。MIGでは、A100のGPUを最大7つの独立したインスタンスに分割することができ、複数のユーザーがGPUアクセラレーションにアクセスできるようになります。A100 40GBでは、各MIGインスタンスに最大5GBまで割り当てることができ、A100 80GBのメモリ容量の増加により、そのサイズは2倍の10GBになります。

MIGは、Kubernetes、コンテナ、ハイパーバイザーベースのサーバー仮想化と連携します。MIGを使用することで、インフラストラクチャ管理者は、各ジョブに対してサービス品質(QoS)を保した適切なサイズのGPUを提供することができ、高速化されたコンピューティングリソースの範囲をすべてのユーザーに拡大することができます。

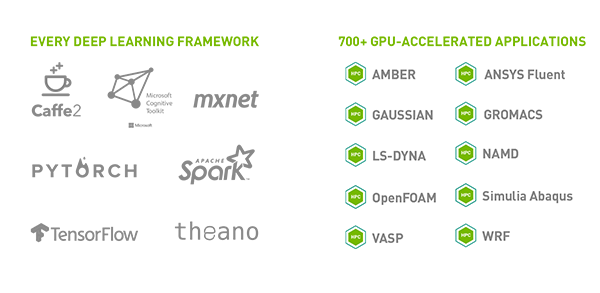

このプラットフォームは、700以上のHPCアプリケーションとあらゆる主要なディープラーニングフレームワークを高速化します。デスクトップからサーバー、クラウドサービスまで、あらゆる場所で利用可能で、劇的なパフォーマンス向上とコスト削減の機会を提供します。

| NVIDIA A100 (PCIe モデル) | |

| GPU アーキテクチャ | NVIDIA Ampere |

| ピーク FP64 | 9.7 TF |

| ピーク FP64 Tensor コア | 19.5 TF |

| ピーク FP32 | 19.5 TF |

| ピーク TF32 Tensor コア | 156 TF | 312 TF* |

| ピーク BFLOAT16 Tensor コア | 312 TF | 624 TF* |

| ピーク FP16 Tensor コア | 312 TF | 624 TF* |

| ピーク INT8 Tensor コア | 624 TOPS | 1,248 TOPS* |

|

ピーク INT4 Tensor コア |

1,248 TOPS | 2,496 TOPS* |

| GPU メモリ | 40 GB |

| GPU メモリ 帯域幅 | 1,555 GB/s |

| 相互接続 | NVIDIA NVLink 600 GB/s** PCIe Gen4 64 GB/s |

| マルチインスタンス GPU | 最大 7MIGs @5GBの様々なインスタンスサイズ |

| フォームファクター | PCIe |

| 最大 TDP 電力 | 250W |

| 主要アプリケーション実効性能 | 90% |

* スパース行列の場合

** HGX A100 サーバー ボード経由の SXM GPU、最大 2 GPU の NVLink ブリッジ経由の PCIe GPU