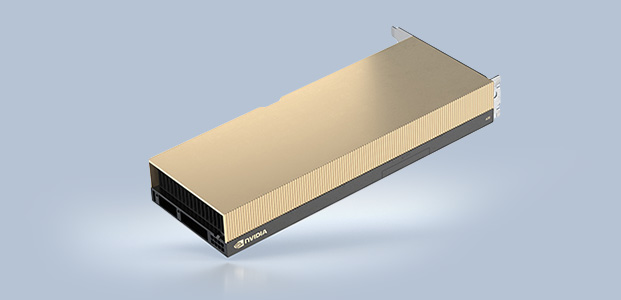

NVIDIA A30 Tensor コア GPU は、企業のあらゆるワークロードのパフォーマンスを高速化します。NVIDIA Ampere アーキテクチャの Tensor コアとマルチインスタンス GPU (MIG)で、大規模な AI 推論やハイパフォーマンス コンピューティング (HPC) アプリケーションといった、多様なワークロードを安全に高速化します。PCIe フォーム ファクターに高速のメモリ帯域幅と少ない電力消費が組み合わされており、メインストリーム サーバーに最適です。A30 はエラスティック データ センターを実現し、企業に最大限の価値をもたらします。

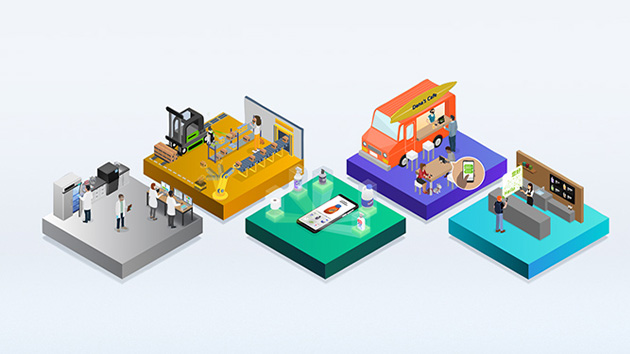

NVIDIA Ampere アーキテクチャは、統合された NVIDIA EGX™ プラットフォームの一部であり、ハードウェア、ネットワーキング、ソフトウェア、ライブラリ、そして NVIDIA NGC™ カタログ内の最適化された AI モデルとアプリケーションのビルディング ブロックを組み合わせます。データ センター向けとして最もパワフルなエンドツーエンド AI/HPC プラットフォームであり、研究者は短期間で実際の成果をあげ、ソリューションを大規模な運用環境に展開できます。

BERT Large ファインチューニング、収束までの時間

対話型 AI といった次のレベルの課題に向けて AI モデルをトレーニングするには、膨大な演算能力とスケーラビリティが必要です。

NVIDIA A30 Tensor コア と Tensor Float (TF32) を利用することで、NVIDIA T4 と比較して最大 10 倍のパフォーマンスがコードを変更することなく得られます。加えて、Automatic Mixed Precision と FP16 の活用でさらに 2 倍の高速化が可能になります。スループットは合わせて 20 倍増えます。 NVIDIA® NVLink®、PCIe Gen4、NVIDIA Mellanox® ネットワーキング、 NVIDIA Magnum IO™SDK と組み合わせることで、数千の GPU までスケールできます。

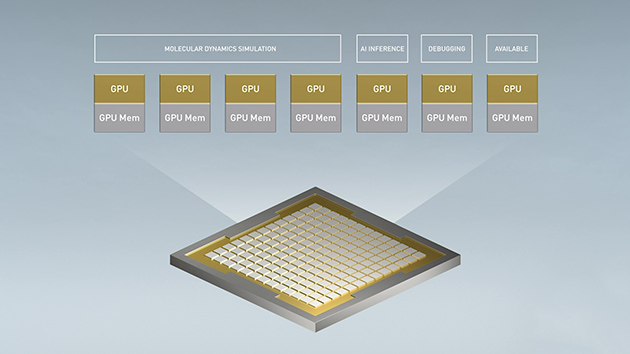

Tensor コアと MIG により、A30 はいつでも柔軟にワークロードを処理できます要求がピークのときには本稼働推論に使用し、オフピーク時には一部の GPU を転用して同じモデルを高速で再トレーニングできます。

NVIDIA は、AI トレーニングの業界標準ベンチマークである MLPerf で複数のパフォーマンス記録を打ち立てています。

A30 には、推論ワークロードを最適化する画期的な機能が導入されています。FP64 から TF32 や INT4 まで、あらゆる精度を加速します。GPU あたり最大 4 つの MIG をサポートする A30 では、安全なハードウェア パーティションで複数のネットワークを同時に運用でき、サービス品質 (QoS) が保証されます。また、スパース構造により、A30 による数々の推論パフォーマンスの向上に加え、さらに最大 2 倍のパフォーマンスがもたらされます。

市場をリードする NVIDIA の AI パフォーマンスは MLPerf 推論で実証されました。AI を簡単に大規模展開する NVIDIA Triton™ 推論サーバー との組み合わせで、A30 はあらゆる企業に圧倒的なパフォーマンスをもたらします。

BERT Large 推論 (正規化済み)

レイテンシ 10 ms 未満でのスループット

RN50 v1.5推論 (正規化)

7ms 以下のレイテンシでのスループット<7ms Latency

LAMMPS (正規化済み)

科学者たちは次世代の発見のため、私たちを取り巻いている世界をより良く理解しようと、シミュレーションに関心を向けています。

NVIDIA A30 は FP64 の NVIDIA Ampere アーキテクチャ Tensor コアを備えています。これは、GPU の導入以来の、HPC パフォーマンスにおける最大級の飛躍です。帯域幅が毎秒 933 ギガバイト (GB/s) の GPU メモリ 24 ギガバイト (GB) との組み合わせにより、研究者は倍精度計算を短時間で解決できます。HPC アプリケーションで TF32 を活用すれば、単精度の密行列積演算のスループットを上げることができます。

FP64 Tensor コアと MIG の組み合わせにより、研究機関は、GPU を安全に分割して複数の研究者がコンピューティング リソースを利用できるようにし、QoS を保証し、GPU 使用率を最大限まで高めることができます。AI を展開している企業は要求のピーク時に A30 を推論に利用し、オフピーク時には同じコンピューティング サーバーを HPC や AI トレーニングのワークロードに転用できます。

データ サイエンティストは、大量のデータセットを分析し、可視化し、インサイトに変えられる能力を求めています。しかしながら、スケールアウト ソリューションは行き詰まることが多々あります。複数のサーバー間でデータセットが分散されるためです。

A30 搭載のアクセラレーテッド サーバーは、必要とされる演算能力、HBM2 大容量メモリ、毎秒 933 GB のメモリ帯域幅、NVLink によるスケーラビリティをもたらし、こうしたワークロードに対処します。NVIDIA InfiniBand、NVIDIA Magnum IO、RAPIDS™ オーブンソース ライブラリ スイート (RAPIDS Accelerator for Apache Spark を含む) との組み合わせにより、NVIDIA データ センター プラットフォームは、かつてないレベルのパフォーマンスと効率性で、こうした巨大なワークロードを高速化します。

A30 と MIG の組み合わせは、GPU 対応インフラストラクチャの使用率を最大限に高めます。MIG を利用することで、A30 GPU を 4 つもの独立したインスタンスに分割できます。複数のユーザーが GPU アクセラレーションを利用できます。.

MIG は、Kubernetes、コンテナー、 ハイパーバイザーベースのサーバー仮想化と連動します。MIG を利用することで、インフラストラクチャ管理者はあらゆるジョブに適切なサイズの GPU を提供し、QoS を保証できます。アクセラレーテッド コンピューティング リソースをすべてのユーザーに届けることが可能になります。

NVIDIA AI Enterprise は、AI とデータ分析ソフトウェアのエンドツーエンドのクラウドネイティブ スイートです。VMware vSphere が含まれるハイパーバイザーベースの仮想インフラストラクチャにおいて、A30 上で実行できることが認定されています。これにより、ハイブリッド クラウド環境で AI ワークロードを管理、拡張できます。

NVIDIA-Certified Systems™ と NVIDIA A30 の組み合わせにより、NVIDIA の OEM パートナーが構築および販売するエンタープライズ データ センター サーバーでは、コンピューティングが加速するうえ、高速かつ安全な NVIDIA ネットワーキングを利用することもできます。このプログラムでは、費用対効果が高くスケーラブルな 1 つの高性能インフラストラクチャで、NVIDIA NGC カタログ内のオーソドックスな AI アプリケーションと多彩な最新式 AI アプリケーションのためのシステムを特定、入手、展開できます。

| FP64 | 5.2 teraFLOPS |

| FP64 Tensor コア | 10.3 teraFLOPS |

| FP32 | 10.3 teraFLOPS |

| TF32 Tensor コア | 82 teraFLOPS | 165 teraFLOPS* |

| BFLOAT16 Tensor コア | 165 teraFLOPS | 330 teraFLOPS* |

| FP16 Tensor コア | 165 teraFLOPS | 330 teraFLOPS* |

| INT8 Tensor コア | 330 TOPS | 661 TOPS* |

| INT4 Tensor コア | 661 TOPS | 1321 TOPS* |

| メディア エンジン | optical flow accelerator (OFA) ×1 JPEG デコーダー (NVJPEG) ×1 ビデオ デコーダー (NVDEC) ×4 |

| GPU メモリ | 24GB HBM2 |

| GPU メモリ帯域幅 | 933GB/s |

| 相互接続 | PCIe Gen4: 64GB/s 第 3 世代 NVLINK: 200 GB/s** |

| フォーム ファクター | デュアルスロット、フルハイト・フルレングス (FHFL) |

| 最大熱設計電力 (TDP) | 165W |

| マルチインスタンス GPU (MIG) | 6 GB GPU インスタンス ×4 12 GB GPU インスタンス ×2 24 GB GPU インスタンス ×1 |

| 仮想 GPU (vGPU) ソフトウェア サポート | VMware 向け NVIDIA AI Enterprise NVIDIA 仮想コンピューティング サーバー |

* 疎性あり

** 最大 2 つの GPU の NVLink ブリッジ